生成AI

ビデオデータの解きほぐし

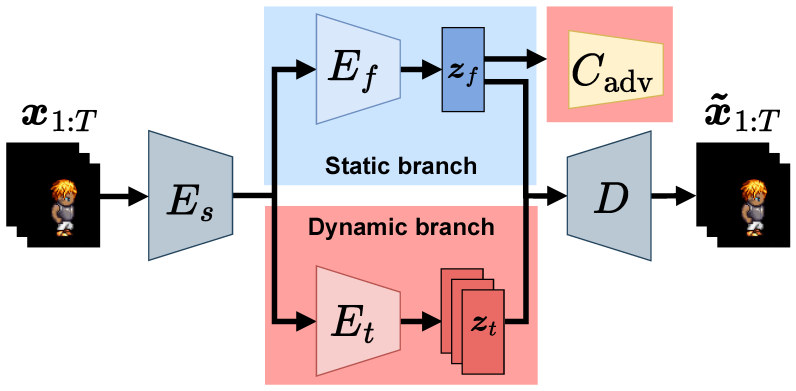

本論文では、ビデオの分離に使用できる表現学習方法である、ビデオのための逐次的変分オートエンコーダーを提案します。これは、静的および動的特徴をビデオから別々に抽出することができます。2ストリームアーキテクチャを持つ逐次的変分オートエンコーダーの構築は、ビデオの分離に対する帰納的バイアスを生み出します。しかし、予備実験で、静的特徴が頻繁に動的特徴を含んでいるため、2ストリームアーキテクチャはビデオの分離に不十分であることが示されました。さらに、潜在空間での動的特徴が識別的でないこともわかりました。これらの問題に対処するため、我々は教師あり学習を用いた敵対的分類器を2ストリームアーキテクチャに導入しました。教師付きの強い帰納的バイアスにより、動的特徴は静的特徴から分離され、動的特徴の識別的な表現が得られます。他の逐次的変分オートエンコーダーとの比較を通じて、我々はSpritesとMUGデータセットにおける提案方法の有効性を質的および量的に実証します。

Haga, Takeshi, Hiroshi Kera, and Kazuhiko Kawamoto, Sequential Variational Autoencoder with Adversarial Classifier for Video Disentanglement, Sensors 23, no. 5: 2515, 2023 [paper].

芳賀壮,計良宥志,川本一彦,動画像の解きほぐしに向けた敵対的補助分類器の効果検証,信学技報PRMU2022-21,Vol.122,No.181,pp.67-71, 2022(電子情報通信学会PRMU研究会の月間ベストプレゼンテーション賞)[paper].

フロー転写による画像アニメーション

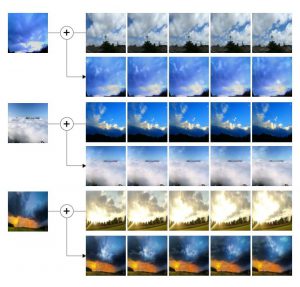

静止画像を動画化(アニメーション化)するための深層学習モデルの開発を進めています.我々の研究では,静止画像とは別の風景の動画を用意し,その動画の動き(フロー)を静止画像へ転写することによって動画化しています.

Kazuma Kurisaki and Kazuhiko Kawamoto, Animating Cloud Images With Flow Style Transfer, IEEE Access, Vol.9, pp.3269-3277, 2021 [paper][GitHub].

Food ASMRビデオからの食感音の生成

我々は、無音の食事ビデオから食品の食感音を生成するための音声・映像モデルを提案します。このモデルは、検出された顔の視覚的特徴を入力として受け取り、視覚ストリームと整合する大きさのスペクトログラムを出力する、ディープネットワークベースのモデルです。与えられた入力視覚ストリームから直接生波形サンプルを生成することは困難です。この研究では、予測された大きさから位相を回復するためにグリフィン・リムアルゴリズムを使用し、逆短時間フーリエ変換を使用して生波形サンプルを生成しました。さらに、我々はこれらの大きさスペクトログラムから例に基づく合成手順を用いて波形を生成しました。モデルを訓練するために、我々はいくつかのASMR(autonomous sensory meridian response)ビデオを含むデータセットを作成しました。我々はこのデータセットでモデルを評価し、予測された音の特徴が視覚入力と適切な時間同期を示すことを発見しました。我々の主観的評価実験は、予測された音が「本物」または「偽物」の心理物理実験で参加者をだますほど現実的であることを示しました。

Kodai Uchiyama and Kazuhiko Kawamoto, Audio-Visual Model for Generating Eating Sounds Using Food ASMR Videos, IEEE Access, Vol.9, pp.50106-50111, 2021 [paper][GitHub].

深層学習による構成的ゼロショットビデオ生成

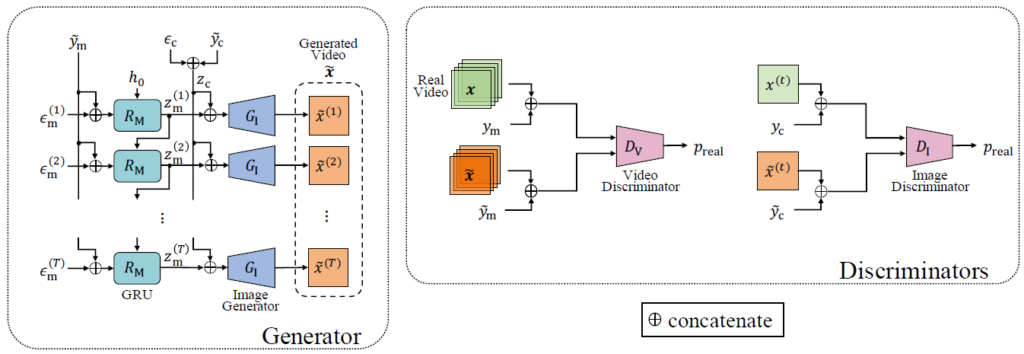

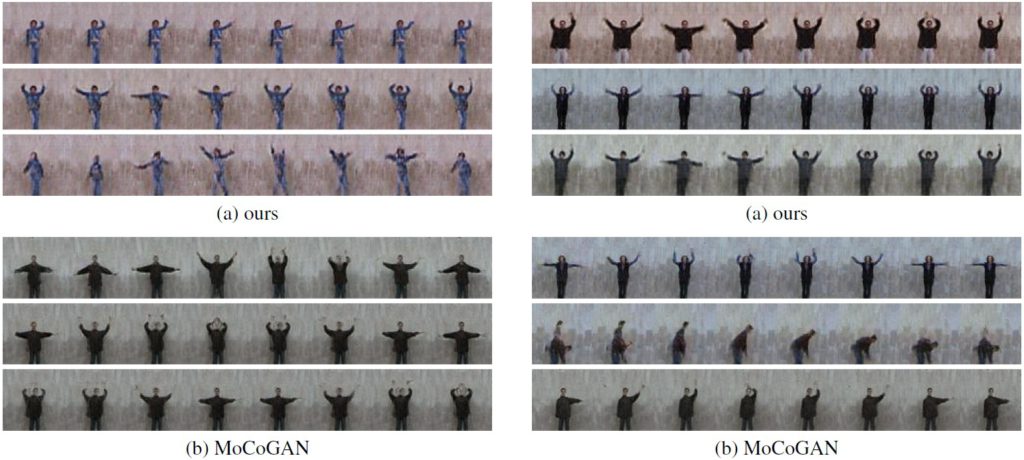

ゼロショット映像生成のための条件付き生成敵対ネットワーク(GAN)モデルを提案する.本研究では,構成的ゼロショット条件付き生成の設定について検討する.すなわち,クラスが一部欠損している学習サンプルからゼロショット動画を生成する.このタスクは条件付きデータ生成の拡張である.キーとなるアイデアは,GANの潜在空間において分離された表現を学習することである.この目的を実現するために,我々は画像生成のための動きと内容を分解したGANと条件付きGANをベースとしたモデルを構築する.我々は,より良い分離表現を見つけ,良質な動画を生成するためのモデルを構築する.提案モデルの有効性をWeizmann行動データベースとMUG表情データベースを用いた実験により実証する.

Shun Kimura and Kazuhiko Kawamoto, "Conditional Motion and Content Decomposed GAN for Zero-Short Video Generation," In Proc. of the 7th International Workshop on Advanced Computational Intelligence and Intelligent Informatics, 2021 [arXix].

木村駿,川本一彦,ゼロショット動画生成のための条件付きMoCoGAN,3Rin4-06, 第34回人工知能学会全国大会, 2020 [paper].

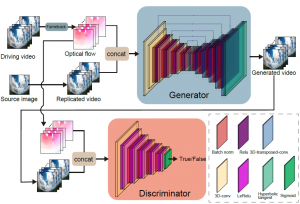

GANによるデプス推定とカラー変換を用いたビデオ生成

ここ数年,映像生成のための生成的敵対ネットワーク(GAN)がいくつか提案されているが,そのほとんどはカラー映像のみを用いて生成モデルを学習している.しかし,シーンのダイナミクスをより正確に理解するためには,光学的な情報だけでなく,3次元的な幾何学的な情報も重要である.本論文では,カラー映像に加え,奥行き映像も用いることで,映像生成のためのGANアーキテクチャを提案する.本アーキテクチャの生成器では,前半に奥行き映像を生成し,後半に奥行きから色への領域変換を解いて色映像を生成する.奥行き情報に着目してシーンのダイナミクスをモデル化することで,従来手法よりも高品質な映像を生成することができた.さらに.顔の表情やハンドジェスチャーのデータセットで評価したところ,本手法が従来手法よりも種類と品質の両面で優れた映像サンプルを生成することを示した.

Y. Nakahira and K. Kawamoto, DCVGAN: Depth Conditional Video Generation, IEEE International Conference on Image Processing (ICIP), pp. 749-753, 2019 [paper][GitHub].

Y. Nakahira and K. Kawamoto, Generative adversarial networks for generating RGB-D videos, Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC), pp. 1276-1281, 2018 [paper].

中平有樹, 川本一彦, デプスからカラーへのドメイン変換を用いたGANによる動画生成,情報処理学会研究報告. Vol. 2018-CVIM-213, No.32, pp.1-7, 2018 (CVIM研究会奨励賞受賞) [paper].

中平有樹, 川本一彦, RGB-D動画生成のためのGAN,情報処理学会研究報告. Vol. 2018-CVIM-212, No.28, pp.1-7, 2018 [paper].