ゼロショット行動認識

スケルトンデータを用いた3ストリームグラフ畳み込みニューラルネットワーク

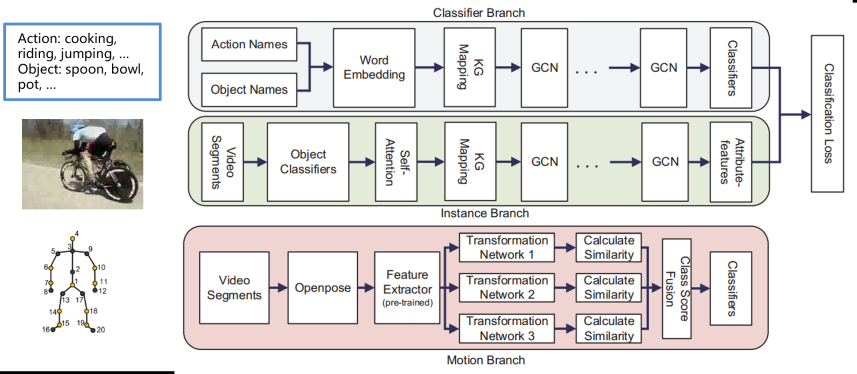

行動認識の精度を向上させるために,大規模なデータセットがよく利用される.しかし、非常に大規模なデータセットには,アノテーションに手間がかかるなどの問題がある.このため,ゼロショット行動認識(ZSAR)の研究が進められている.現在,多くのZSAR手法は,各映像フレームに応じて行動を認識している.しかし,これらの手法は,光,カメラの角度,背景の影響を受けやすい.さらに時系列データを処理できないものがほとんどであり,時系列データを扱うことができないため,モデルの精度が低下してしまう.本論文では,これらの問題を解決するために,2種類のデータを処理する3ストリームグラフ畳み込みネットワークを提案する.このモデルは2つの部分から構成される.一つは,有用な情報が多く含まれるRGBデータを処理する部分である.もう1つは,光や背景の影響を受けないスケルトンデータを処理する部分である.この2つの出力を加重和することで,ZSARの最終結果を予測する.3つのデータセットで実験を行った結果,本モデルがベースラインモデルよりも高い精度を持つことを実証した.さらに,我々のモデルが人間の経験から学習することでより精度の高いモデルを実現できることも証明する.

Wu, Nan; Kawamoto, Kazuhiko. 2021. "Zero-Shot Action Recognition with Three-Stream Graph Convolutional Networks" Sensors 21, no. 11: 3793 [paper].

テキスト記述を用いた画像-言語アプローチによる精度向上

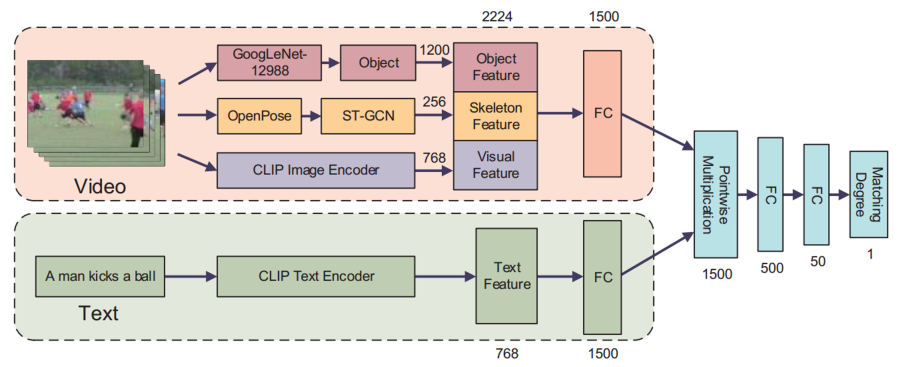

トレーニング例を受け取らずにビデオ内のアクションを認識するゼロショットアクション認識は、労働コストとトレーニング時間を節約できることから、広く注目を集めています。それにもかかわらず、ゼロショット学習の性能はまだ満足できるものではなく、その実用的な応用を制限しています。この問題を解決するために、本研究では、テキスト記述を伴う人間の指示を使用してゼロショットアクション認識を改善するフレームワークを提案します。提案されたフレームワークでは、ビデオの内容を手動で記述することにより、ある程度の労働コストが発生しますが、多くの場合、そのコストはそれだけの価値があります。各アクションについて、単語、フレーズ、または文でテキスト特徴を手動で注釈します。次に、ビデオとすべてのテキスト特徴の間のマッチング度合いを計算することで、ビデオのクラスを予測することができます。さらに、提案されたモデルは他のモデルと組み合わせて精度を向上させることもできます。加えて、人間の指示を繰り返すことにより、精度を向上させるためにモデルを継続的に最適化することができます。UCF101およびHMDB51での結果は、私たちのモデルが最高の精度を達成し、他のモデルの精度を向上させたことを示しています。

Nan Wu, Hiroshi Kera, and Kazuhiko Kawamoto, Improving zero-shot action recognition using human instruction with text description, Applied Intelligence, vol.53, pp.24142–24156, 2023 [paper][SharedIt][arXix].

大規模言語モデルを用いたゼロショット行動認識

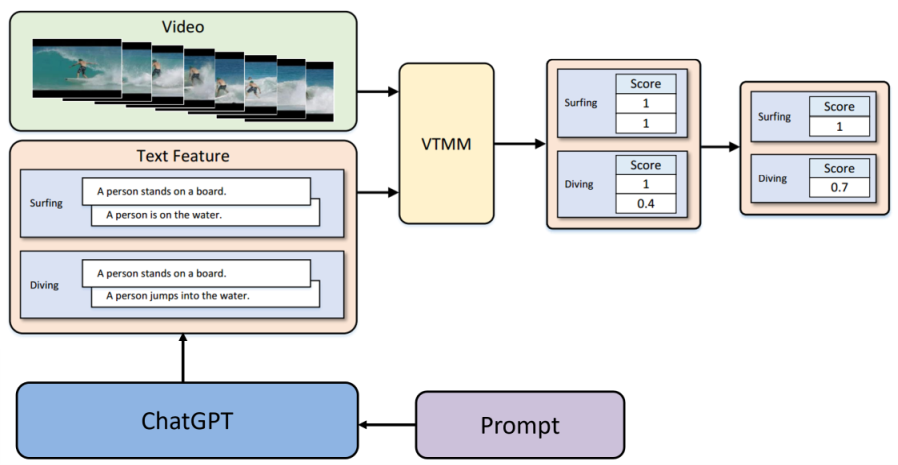

ディープラーニングが進化し続ける中、データセットはますます大きくなり、手動でのラベリングにかかるコストが高くなっています。ゼロショット学習は、トレーニングデータセットをラベル付けするための大幅な労働コストを必要としなくなります。さらに、この方法では、わずかな修正で新しいクラスを予測することが可能です。しかし、ゼロショット学習の精度は依然として比較的低く、実用的な応用が困難です。最近の研究では、手動で特徴を注釈することにより精度を向上させようとしていますが、このアプローチもまた、労働集約的な入力を必要とします。これらの労働コストを削減するために、私たちはChatGPTを使用しています。ChatGPTは、手動での関与なしに自動的に特徴を生成することができます。重要なことに、このアプローチは高い精度レベルを維持し、他の自動化された方法を上回っています。

Nan Wu, Hiroshi Kera, and Kazuhiko Kawamoto, Zero-Shot Action Recognition with ChatGPT-based Instruction, Advanced Computational Intelligence and Intelligent Informatics, Communications in Computer and Information Science, vol. 1932, pp.18-28, 2024 [paper].